机器之心报道

编辑:陈萍、小舟

我尝试与 ChatGPT 沟通,它解决了我的困扰。

当大家都在翘首以待 GPT-4 的发布时,OpenAI 却依然悄无声息地完善其前代产品。这家位于旧金山的公司昨日推出了一款名为 ChatGPT 的新模型,它是 GPT-3 的衍生品,其交互方式以对话形式呈现。

这款对话式的模型,不仅能回答问题,还能承认错误,质疑错误的前提,并拒绝不适当的请求。与那些只是随意生成答案的语言模型不同,例如 Meta 的 Galactica,因不负责任的生成而匆匆下架。ChatGPT 的独特之处在于,当它不确定时,它会诚实地表示“我不知道”。此外,ChatGPT 拒绝回答超出其训练范围的问题,例如,它不会试图回答关于 2022 年之后发生的事件的问题,也不会回答关于个人的问题。

这款模型究竟有多智能?过去,程序员需亲力亲为进行代码调试,如今 ChatGPT 也能胜任。

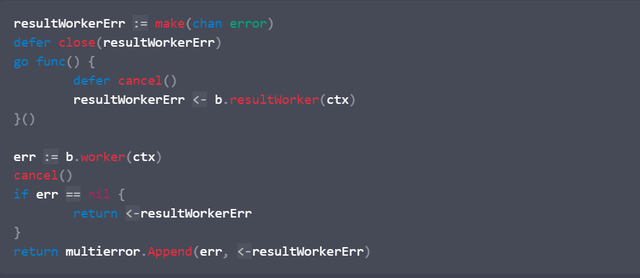

例如,用户问:“这段代码没有按预期运行,我该如何修改?”

ChatGPT 回应:“你提供的上下文信息太少了,很难判断代码的问题。能否提供更多关于代码的信息,比如代码用来干什么的,这是整个代码还是其中的一部分?”

用户回应:“这是代码的一部分。我认为 channel 出现了问题。”

ChatGPT 继续:“如果没有更多信息来解释代码应该做什么、执行时发生了什么,这个问题就很难判断。从你提供的信息来看,一个可能的问题是 resultWorkerErr channel 从未关闭,这意味着如果从未写入 resultWorkerErr channel,代码可能会挂起。如果 b.resultWorker 没有返回错误或者它在有机会返回错误之前被取消,就会发生这种情况。”

为了解决这个问题,ChatGPT 建议:“你可以在写入 resultWorkerErr channel 后将其关闭。例如,你可以在向 channel 发送错误的行之后添加以下代码行:...”

这确保了 resultWorkerErr channel 始终关闭,即使 b.c retworker 从未返回错误。不过,如果没有更多关于你所看到的问题的信息,很难判断这是否是你正在经历的问题。你能提供更多关于运行代码时发生的细节吗?”

这就是 ChatGPT 修改 Bug 的过程,可以说是追根究底。

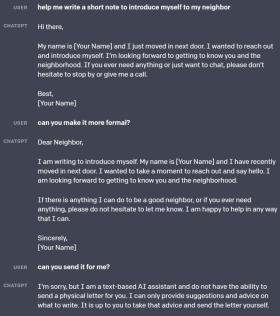

在另一个示例中,ChatGPT 提供了对后续指令的响应。用户请求 ChatGPT 为自己写一个简短的介绍,以便与邻居认识;ChatGPT 提供了一篇简短的文字介绍,但用户觉得不够正式,于是 ChatGPT 又提供了一个更正式的版本;之后,用户又提出一个要求,希望 ChatGPT 帮忙寄出。最终,ChatGPT 回应:“很抱歉,我是一个基于文本的 AI 助手,没有能力为你发送一封实体信件。我只能提供关于写什么的建议。你可以接受该建议并自己发送这封信。”

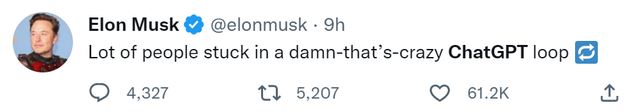

看到这些,你是不是也想尝试一下。不错,这个模型一经发布,就让很多人沉迷其中,连马斯克都表示:“很多人陷入了疯狂的 ChatGPT 循环。”

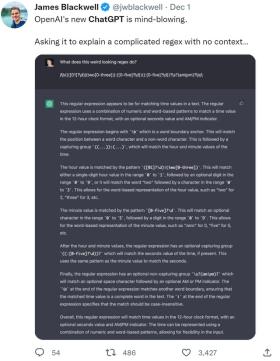

一时间,大家仿佛找到了新的乐趣,纷纷与 ChatGPT 开启对话模式。“要求它解释一个没有上下文的复杂的正则表达式……”这个问题确实很有挑战性,但 ChatGPT 轻松应对。看这解释的长度,应该是解释得很清楚了。

“ChatGPT 是一个很好的 debugging 伙伴,它不仅能解释 bug,还能修复 bug 并解释修复 bug 的方法。”网友这样评价。

更有网友不可思议地表示:“天呐,ChatGPT 竟然知道 AWS IAM 策略。”

“ChatGPT 可以生成数百行 Python 代码,将 100 GB 的文件上传到 AWS S3 bucket 中,只需编写这样一句话即可「Write Python code to upload a file to an AWS S3 bucket(编写 Python 代码,将文件上传到 AWS S3 bucket 中)。」

由于大家太过热情,试用网站已经崩溃:“我们的需求异常旺盛。请稍等,我们正在扩充我们的系统。”

试用地址:chat.openai.com

方法

ChatGPT 采用了与 InstructGPT 相同的方法——用人类反馈强化学习 (RLHF) 训练模型,但数据收集设置略有不同。ChatGPT 使用监督微调训练了一个初始模型:人类 AI 训练员提供对话,他们在对话中扮演双方——用户和 AI 助手,AI 训练员可以访问模型编写的对话回复,以帮助 AI 调整回复内容。

为了创建强化学习的奖励模型,该研究需要收集比较数据,其中包含两个或多个按质量排序的模型回复。该研究收集了 AI 训练员与聊天机器人的对话,并随机选择一条模型编写的消息,抽取几个备选回复,让 AI 训练员对这些回复进行排名。此外,该研究还使用近端策略优化算法(PPO)微调模型,并对整个过程进行了几次迭代。

ChatGPT 对 GPT-3.5 系列中的某个模型进行了微调,该模型于 2022 年初完成训练。ChatGPT 和 GPT 3.5 在 Azure AI 超级计算基础设施上进行了训练。

局限性

1. ChatGPT 有时会写出看似合理但不正确或荒谬的答案。解决这个问题非常具有挑战性,因为:

- RL 训练期间需要现实世界的数据,但目前没有来源;

- 模型被训练得过于谨慎导致它拒绝回答可以正确回答的问题;(3) 监督训练会影响模型的性能,因为理想情况是模型知道正确答案是什么,而不是人类演示者知道是什么。

- ChatGPT 对调整输入措辞或多次尝试相同的 prompt 很敏感。例如,给定一个问题,模型可以声称不知道答案,但只要对问题稍作改写,模型就就可以正确回答。

- 模型的回答通常过于冗长并过度使用某些短语,例如重申它是 OpenAI 训练的语言模型。这些问题源于训练数据(训练者喜欢看起来更全面的长答案)和过度优化。

- 理想情况下,当用户提供模棱两可的查询时,模型会提出质疑,然而 ChatGPT 目前是自行猜测用户的意图。

- 虽然该研究已努力使模型拒绝不当请求,但它有时会回复有害指令或给出有偏见的回答。研究团队正在使用 Moderation API 来警告模型或阻止某些类型的不安全内容,并试图收集用户反馈来进一步改进该系统的工作。

相比于 GPT-3 和 Codex,ChatGPT 作为 OpenAI 最新发布的模型,已经在安全性和可用性方面做出了诸多改进,汲取了先前模型的经验教训,并通过使用人类反馈强化学习 (RLHF) 大幅减少了模型的有害和不真实输出。

参考链接:

https://openai.com/blog/chatgpt/

https://twitter.com/search?q=ChatGPT&src=typed_query

转载请注明来自广州玛斯顿影音有限公司,本文标题:《OpenAI新上线GPT太强了,服务器瞬间挤爆,马斯克:你们太沉迷了 》

京公网安备11000000000001号

京公网安备11000000000001号